Versionen im Vergleich

Schlüssel

- Diese Zeile wurde hinzugefügt.

- Diese Zeile wurde entfernt.

- Formatierung wurde geändert.

Es ist möglich auf die Filesysteme des Clusters auch von außerhalb zuzugreifen. Dabei muss zwischen /home und dem parallelen Filesystem /gpfs unterschieden werden.

| Hinweis | ||

|---|---|---|

| ||

Wenn Sie das Gefühl haben, dass ihre Datenverbindungen langsam sind, wenden Sie sich bitte an das HPC-Team. Möglicherweise muss eine Bandbreiten-Einschränkung der UKD-IT für Sie deaktiviert werden. |

/home

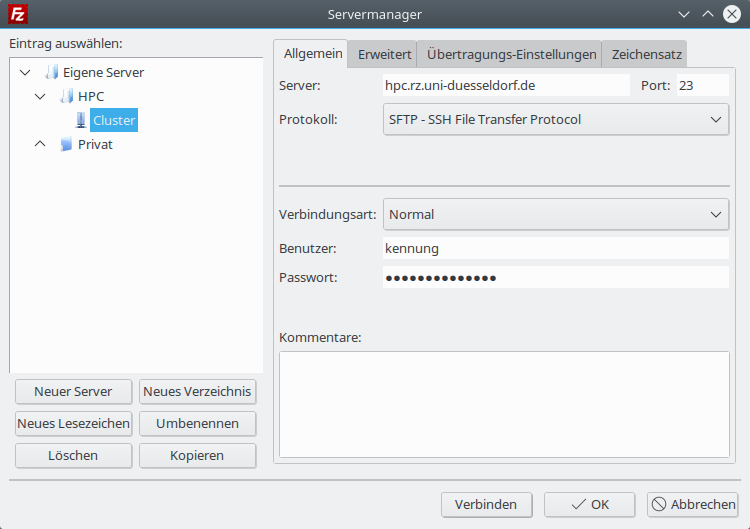

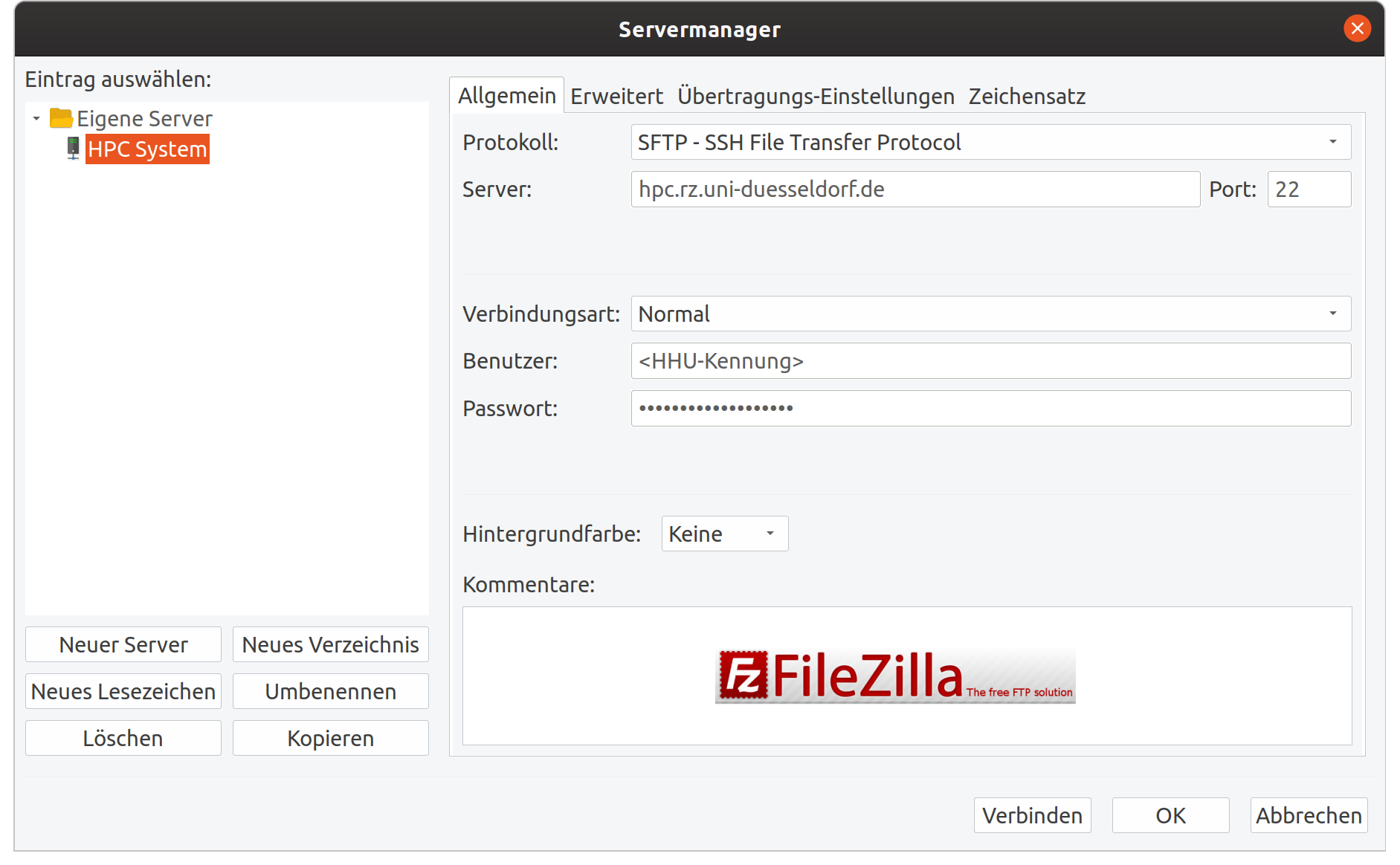

Der Zugriff auf die Verzeichnisse /home ist lediglich über die Dateiübertragungsprotokolle SCP oder SFTP möglich. Für SFTP gibt es beispielsweise die Anwendung FileZilla, welche auf allen Plattformen verfügbar ist:

Einstellungen für FileZilla

Image Removed

Image Removed Image Added

Image Added

Zugang per SSHFS

Linux

Unter Linux gibt es das Paket sshfs, welches ein Remote-File-System per Fuse mountbar macht. Wenn man dieses Programm installiert hat, kann man folgenden Befehl verwenden:

| Codeblock | ||

|---|---|---|

| ||

mkdir -p ~/mounts/cluster/home sshfs kennung@storage.hpc.rz.uni-duesseldorf.de:/home/kennung ~/mounts/cluster/home |

Windows

Unter Windows gibt es das Programm Programm ExpanDrive und SFTP Net-Drive, welche SFTP-Ordner als Netzlaufwerk im Explorer zur Verfügung stellen.

Mac OSX

Unter OSX benötigt man die Programme OSXFuse und SSHFS von https://osxfuse.github.io.

Nachdem die Programme korrekt installiert wurden, lassen sich die Verzeichnisse mit den Befehlen aus der Linux-Anleitung über die Konsole mounten.

/gpfs

| Info | ||

|---|---|---|

| ||

| Der Login-Knoten ist vergleichsweise langsam, aber dafür weltweit erreichbar. Hingegen ist der Storage-Server schnell, aber dafür nur vom HHU-Netz aus erreichbar. Möchten Sie ihn dennoch von außerhalb (z. B. vom Home-Office aus) verwenden, können Sie eine VPN-Verbindung nutzen. |

Zugriff per CIFS / Samba

Es ist möglich auf die Filesysteme /gpfs/project und /gpfs/scratch per CIFS unter Windows, Linux und macOS zu mounten.

Der CIFS-Server lautet storage.hpc.rz.uni-duesseldorf.de

Anmelde-Daten:

Domäne: HILBERT-AFM

Benutzername: IDM-Kennung

Password: IDM-Passwort

Freigabe-Namen: project oder scratch

Einrichtung unter Windows

Unter Windows lassen sich die Filesysteme als Netzwerklaufwerk hinzufügen

Einrichtung unter Linux

Einrichtung über fstab

Folgende Zeilen anpassen und in die /etc/fstab eintragen:

| Codeblock | ||

|---|---|---|

| ||

//storage.hpc.rz.uni-duesseldorf.de/project /home/philipp/mounts/cluster/project cifs users,_netdev,credentials=/home/philipp/.smbcredentials,noauto,uid=philipp,gid=philipp,vers=3.0 0 0 //storage.hpc.rz.uni-duesseldorf.de/scratch /home/philipp/mounts/cluster/scratch cifs users,_netdev,credentials=/home/philipp/.smbcredentials,noauto,uid=philipp,gid=philipp,vers=3.0 0 0 |

Danach muss die Datei .smbcredentials angepasst werden:

| Codeblock |

|---|

username=IDM-Kennung password=IDM-Passwort domain=HILBERT-AFM |

Danach sollte sich das Filesystem mit folgenden Befehlen mounten lassen:

| Codeblock |

|---|

mount /home/philipp/mounts/cluster/project mount /home/philipp/mounts/cluster/scratch |

Synchronisation per Rsync oder SFTP

Auch für den Datentransfer mit anderen Protokollen empfiehlt sich der Server storage.hpc.rz.uni-duesseldorf.de, da dort ein redundanter Zugang gewährleistet ist und die Übertragungsraten deutlich höher sein können.

| Inhalt | ||

|---|---|---|

|