- Angelegt von Rehs, Philipp Helo, zuletzt geändert am März 16, 2022

Es ist möglich auf die Filesysteme des Clusters auch von außerhalb zuzugreifen. Alle Filesysteme werden dabei über storage.hpc.rz.uni-duesseldorf.de per CIFS freigegeben. Dieser Server kann auch für Transfers mit rsync oder SCP/SFTP verwendet werden.

Hinweis für UKD und Medizin

Wenn Sie das Gefühl haben, dass ihre Datenverbindungen langsam sind, wenden Sie sich bitte an das HPC-Team. Möglicherweise muss eine Bandbreiten-Einschränkung der UKD-IT für Sie deaktiviert werden.

Externe Datentransfers

Wenn Sie Daten mit externen Nutzer*Innen teilen wollen, oder auf den Cluster herunterladen wollen, empfehlen wir die Nutzung von Globus Connect. Diese ist im Wiki unter Datenübertragung mit Globus Connect beschrieben.

Passwordlose Anmeldung

Sollte ihr System sich in der Windows-Domäne befinden oder ein Kerberos-Ticket besitzen, ist eine Authentifizierung ohne Password-Eingabe bei CIFS/Samba möglich. Eine Anleitung zum Einrichten eines Kerberos-Tickets finden sie hier.

Zugriff per sshfs (Nur Mac / Linux)

Die größtmögliche Performanz und Linux-Kompatibilität sowie den geringsten Konfigurationsaufwand bietet die Verwendung der Dateisysteme mittels sshfs. Dabei wird das sehr sichere, stabile und schnelle SSH-Protokoll für die Dateiübertragung verwendet, das auch bereits beim interaktiven Zugriff auf den Cluster zum Einsatz kommt. Wenn für die normale ssh-Verbindung bereits ein passwortloser Login konfiguriert wurde, verwendet sshfs ebenfalls automatisch diese Konfiguration.

Dazu müssen lediglich die Zielverzeichnisse erstellt werden, unter dem die HPC-Dateisysteme lokal verfügbar sein sollen. Gemäß den Linux-Standards empfiehlt sich dafür der Ordner /mnt:

sudo mkdir /mnt/hpc-project /mnt/hpc-scratch /mnt/hpc-home sudo chown $USER:$USER /mnt/hpc-project /mnt/hpc-scratch /mnt/hpc-home

Anschließend kann bereits der Befehl sshfs verwendet werden, um die Dateisysteme des Clusters lokal verfügbar zu machen:

sshfs Unikennung@storage.hpc.rz.uni-duesseldorf.de:/gpfs/project /mnt/hpc-project sshfs Unikennung@storage.hpc.rz.uni-duesseldorf.de:/gpfs/scratch /mnt/hpc-scratch sshfs Unikennung@storage.hpc.rz.uni-duesseldorf.de: /mnt/hpc-home

Falls der Befehl sshfs nicht gefunden werden kann, muss dieser ggf. noch über das gleichnamige Paket auf ihrem lokalen Rechner installiert werden. Unter Debian / Ubuntu und Derivaten genügt dazu der folgende Befehl:

sudo apt install sshfs

Mac OS

Für NutzerInnen von mac OS sollte die Anleitung analog funktionieren. Lediglich die Dateipfade unter /mnt müssen auf einen anderen Ordner geändert werden, z.B. innerhalb des Benutzerverzeichnisses:

mkdir -p ~/mnt/hpc-project ~/mnt/hpc-scratch ~/mnt/hpc-home

Anschließend kann wie bereits oben der Befehl sshfs verwendet werden, um die Dateisysteme des Clusters lokal verfügbar zu machen:

sshfs Unikennung@storage.hpc.rz.uni-duesseldorf.de:/gpfs/project ~/mnt/hpc-project sshfs Unikennung@storage.hpc.rz.uni-duesseldorf.de:/gpfs/scratch ~/mnt/hpc-scratch sshfs Unikennung@storage.hpc.rz.uni-duesseldorf.de: ~/mnt/hpc-home

Zugriff per rsync (Mac, Linux, Windows per cygwin)

Falls es nicht erforderlich ist, die Dateisysteme des Clusters dauerhaft in der lokalen Verzeichnisstruktur verfügbar zu machen, sondern nur Dateien zu übertragen, empfiehlt sich die Verwendung von rsync. Mit rsync lässt sich die größtmögliche Übertragungsgeschwindigkeit erreichen. Außerdem werden, im Gegensatz zu einem normalen Kopiervorgang, inkrementelle Übertragungen unterstützt. rsync überprüft dazu automatisch, welche Dateien schon am Zielpfad existieren, und überträgt nur die geänderten Dateien. Dies ist insbesondere beim Übertragen von ganzen Verzeichnisstrukturen sehr hilfreich. rsync verwendet analog zu sshfs das SSH-Protokoll, was auch zum Login auf dem Cluster verwendet wird. Falls also bereits ein passwortloser Login konfiguriert wurde, wird dieser ebenfalls automatisch von rsync genutzt.

Die Syntax zur Verwendung von rsync lautet wie folgt:

rsync -aPe ssh /Pfad/zur/ersten/Quelldatei /Pfad/zur/zweiten/Quelldatei [...] /Pfad/zum/Zielverzeichnis

Wenn sich einer der beiden Pfade auf einem entfernten Computer befindet, z.B. auf dem HPC, kann dies mit einem : vor dem Pfad angegeben werden. Um Daten in das eigene GPFS-Verzeichnis hochzuladen, kann also folgender Befehl verwendet werden:

rsync -aPe ssh /Pfad/zur/Quelldatei/auf/dem/lokalen/System Unikennung@storage.hpc.rz.uni-duesseldorf.de:/gpfs/project/Benutzername

Herunderladen funktioniert analog:

rsync -aPe ssh Unikennung@storage.hpc.rz.uni-duesseldorf.de:/gpfs/project/Benutzername/Dateiname /Pfad/zum/Zielverzeichnis/auf/dem/lokalen/System

Anstatt von Quelldateien können natürlich auch ganze Quellverzeichnisse angegeben werden. Ist dabei ein / am Ende des Verzeichnisnamens, so wird das Verzeichnis am Zielort ausgepackt, d.h. nur die Unterordner und Dateien werden übertragen, nicht aber das Verzeichnis selbst. Lässt man den / am Ende des Quellverzeichnisses weg, so wird im Zielverzeichnis ein gleichnamiges Verzeichnis erstellt, und darin die Unterordner und Dateien abgelegt.

Unbedingt die Storageknoten verwenden!

Hierbei ist es wichtig, dass für die Dateiübertragung ebenfalls die Storageknoten unter storage.hpc.rz.uni-duesseldorf.de verwendet werden. Wird der Login-Knoten hpc.rz.uni-duesseldorf.de verwendet, so sind die Transferraten geringer und die Verwendung des Clusters durch andere NutzerInnen wird erheblich beeinträchtigt. Daher werden Verbindungen wie sshfs oder rsync auf dem Login-Knoten automatisch nach ein paar Sekunden wieder getrennt.

Windows

Unter Windows kann das rsync-Kommandozeilentool mittels Cygwin installiert werden. Dazu Cygwin von der Herausgeberseite herunterladen und installieren. Bei der Installation erscheint ein Fenster, in dem die zu installierenden Pakete abgefragt werden. Dort ist ein Haken neben rsync zu setzen. Nach der Installation kann die Cygwin-Befehlszeile über die Desktopverknüpfung gestartet werden. Darin sollte nun das rsync-Programm zur Verfügung stehen. Die Pfade zu den lokalen Festplatten stehen unter Cygwin mittels /cygdrive/c/... zur Verfügung.

Zugriff per CIFS / Samba (Linux, Mac, Windows)

Es ist möglich, die Filesysteme /gpfs/project und /gpfs/scratch sowie das Homeverzeichnis per CIFS unter Windows, Linux und macOS lokal ins Dateisystem einzubinden. Dazu wird folgende Konfiguration empfohlen:

| Bezeichnung | Wert |

|---|---|

| Servername | storage.hpc.rz.uni-duesseldorf.de |

| Domäne: | AD |

| Benutzername: | <IDM-Kennung> |

| Passwort: | <IDM-Passwort> |

| Freigabe-Name: | project, home oder scratch |

Einrichtung unter Windows

Unter Windows lassen sich die HPC Dateisysteme als Netzwerklaufwerk hinzufügen:

Dazu im Windows (Datei-)Explorer bei „Dieser PC“ (1) auf „Netzwerklaufwerk verbinden“ (2) klicken.

Bei den Verbindungseigenschaften als Ordner „\\storage.hpc.rz.uni-duesseldorf.de\project“ (3) eingeben.

(Tipp: Um direkt zu dem persönlichen Projektordner im GPFS zu gelangen, einfach noch „\<Nutzerkürzel>“ anhängen.)

Dann müssen Sie noch den Haken bei „andere Anmeldeinformationen“ (4) setzen und mit „Fertig stellen“ (5) bestätigen.

Bei den darauf folgenden Netzwerkanmeldeinformationen bei Benutzername dann „<Nutzerkürzel>@ad.hhu.de“ (6) angeben.

Zu guter Letzt noch das Passwort (7) eingeben und mit „OK“ (8) bestätigen, danach sollte der HPC Ordner eingebunden werden.

Einrichtung unter Linux

Unter Linux existieren zwei Wege, um die HPC-Dateisysteme ins lokale Dateisystem einzubinden. Der klassische Weg verwendet dazu eine Datei .smbcredentials im Home-Verzeichnis des Nutzers, indem die Zugangsdaten im Klartext abgespeichert werden. Dies stellt allerdings ein mögliches Sicherheitsrisiko dar, da so Unikennung und Passwort für alle lokalen Programme lesbar sind. Sicherer ist daher die Verwendung von Kerberos, bei der die Authentifizierung über ein vom Server ausgestelltes Kerberos-Ticket erfolgt.

Einrichtung mittels .smbcredentials

Folgende Zeilen anpassen und in die /etc/fstab eintragen:

//storage.hpc.rz.uni-duesseldorf.de/project /mnt/hpc-project cifs users,_netdev,credentials=/home/<lokaler Benutzername>/.smbcredentials,noauto,uid=1000,gid=1000 0 0 //storage.hpc.rz.uni-duesseldorf.de/scratch /mnt/hpc-scratch cifs users,_netdev,credentials=/home/<lokaler Benutzername>/.smbcredentials,noauto,uid=1000,gid=1000 0 0 //storage.hpc.rz.uni-duesseldorf.de/home /mnt/hpc-home cifs users,_netdev,credentials=/home/<lokaler Benutzername>/.smbcredentials,noauto,uid=1000,gid=1000 0 0

Gegebenenfalls muss der Wert 1000 bei uid und gid durch den Namen des lokalen Benutzers ersetzt werden, wenn der lokale Benutzer nicht der erste erstellte Benutzer auf dem lokalen System ist. Danach muss die Datei .smbcredentials im Homeverzeichnis des lokalen Nutzers angepasst werden:

username=IDM-Kennung password=IDM-Passwort domain=AD

Die Zielverzeichnisse auf dem lokalen System sollten erstellt und dem lokalen Nutzer übergeben werden:

sudo mkdir /mnt/hpc-project /mnt/hpc-scratch /mnt/hpc-home sudo chown $USER:$USER /mnt/hpc-project /mnt/hpc-scratch /mnt/hpc-home

Danach sollten sich die Dateisysteme mit folgenden Befehlen mounten lassen:

mount /mnt/hpc-project mount /mnt/hpc-scratch mount /mnt/hpc-home

Einrichtung mittels Kerberos

Um ein Kerberos-Ticket zu erzeugen, ist es notwendig, die Kerberos-Client-Tools installiert zu haben. Der Paketname unterscheidet sich dabei zwischen den Linux-Distributionen:

| Distribution | Paketnamen |

|---|---|

| ArchLinux | krb5 |

| Debian | krb5-config krb5-clients krb5-user |

| Ubuntu | krb5-user |

| RHEL / CentOS / Alma Linux / Rocky Linux / Oracle Linux | krb5-workstation krb5-libs |

Bei Debian und Ubuntu werden Sie während der Installation möglicherweise direkt nach dem Kerberos-Realm gefragt. In diesem Fall ist folgender Wert zu Verwenden:

| Realm | AD.HHU.DE |

|---|---|

| CIFS-Server | hilbert-14k.ad.hhu.de |

Beim Realm ist darauf zu achten, dass dieser komplett groß geschrieben wird. Danach kann mit folgendem Befehl ein Ticket erzeugt werden:

kinit -f <Unikennung>@AD.HHU.DE

An dieser Stelle werden Sie nach dem Password zu ihrer Unikennung gefragt, und müssen dieses eintippen. Mit dem folgenden Befehl können Sie überprüfen, ob korrekt ein Ticket erzeugt wurde:

philipp@VM-Rehs ~ $ klist

Ticketzwischenspeicher: FILE:/tmp/.....

Standard-Principal: phreh100@AD.HHU.DE

Valid starting Expires Service principal

26.01.2022 12:26:06 26.01.2022 22:26:06 krbtgt/AD.HHU.DE@AD.HHU.DE

erneuern bis 26.01.2022 22:26:06

Es ist zwingend erforderlich, dass ein Eintrag mit krbtgt in der letzten Spalte und passendem Zeitraum existiert.

Danach kann folgender Eintrag in der /etc/fstab angelegt werden:

//hilbert-14k.ad.hhu.de/project /mnt/hpc-project cifs _netdev,sec=krb5,noauto,user,uid=1000,cruid=1000,gid=1000,rw 0 0 //hilbert-14k.ad.hhu.de/scratch /mnt/hpc-scratch cifs _netdev,sec=krb5,noauto,user,uid=1000,cruid=1000,gid=1000,rw 0 0 //hilbert-14k.ad.hhu.de/home /mnt/hpc-home cifs _netdev,sec=krb5,noauto,user,uid=1000,cruid=1000,gid=1000,rw 0 0

Gegebenenfalls muss der Wert 1000 bei uid, cruid und gid durch den Namen des lokalen Benutzers ersetzt werden, wenn der lokale Benutzer nicht der erste erstellte Benutzer auf dem lokalen System ist. Die Zielverzeichnisse auf dem lokalen System sollten erstellt und dem lokalen Nutzer übergeben werden:

sudo mkdir /mnt/hpc-project /mnt/hpc-scratch /mnt/hpc-home sudo chown $USER:$USER /mnt/hpc-project /mnt/hpc-scratch /mnt/hpc-home

Danach sollten sich die Dateisysteme mit folgenden Befehlen mounten lassen:

mount /mnt/hpc-project mount /mnt/hpc-scratch mount /mnt/hpc-home

Zugriff per SFTP (Alle Systeme)

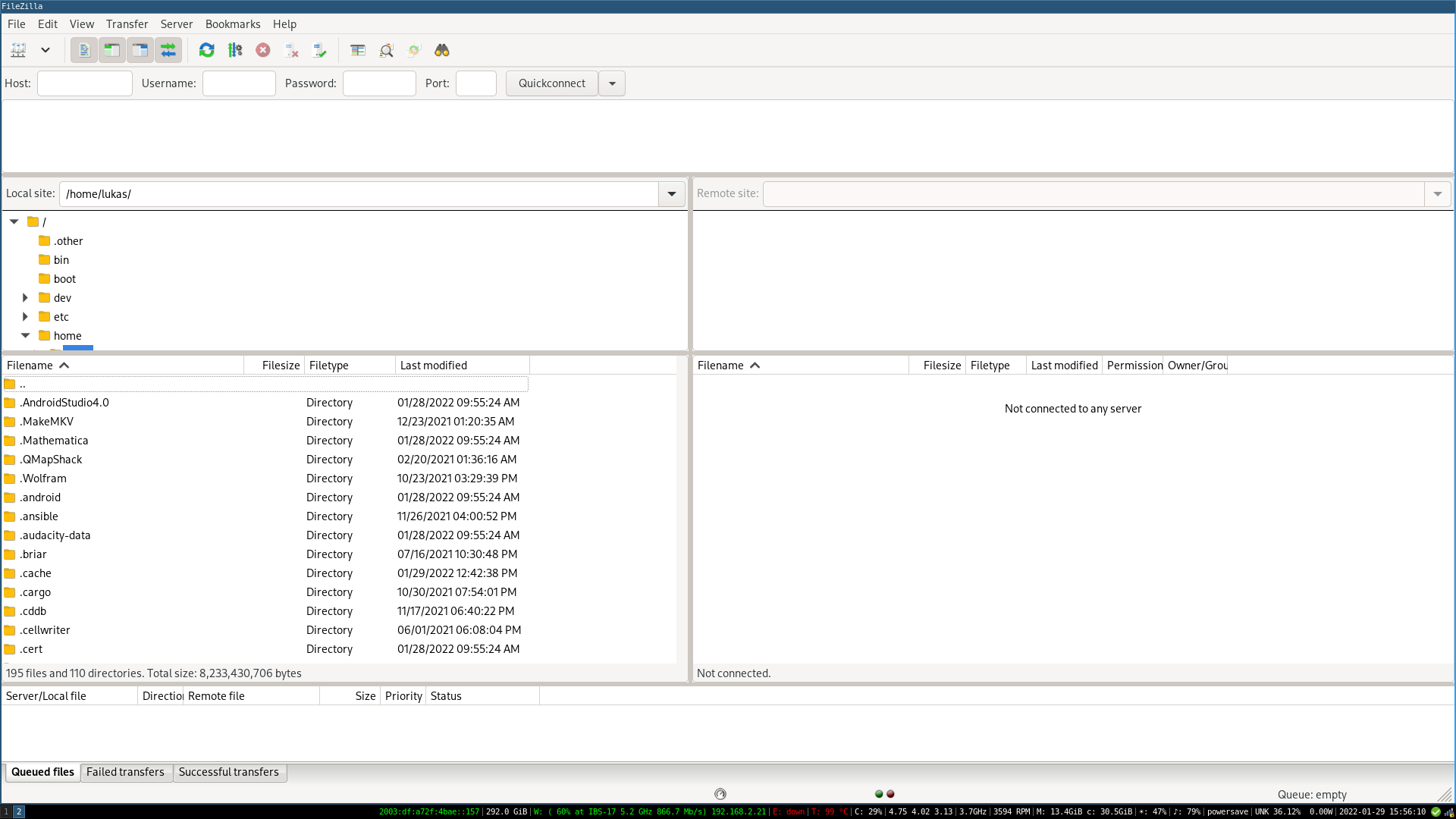

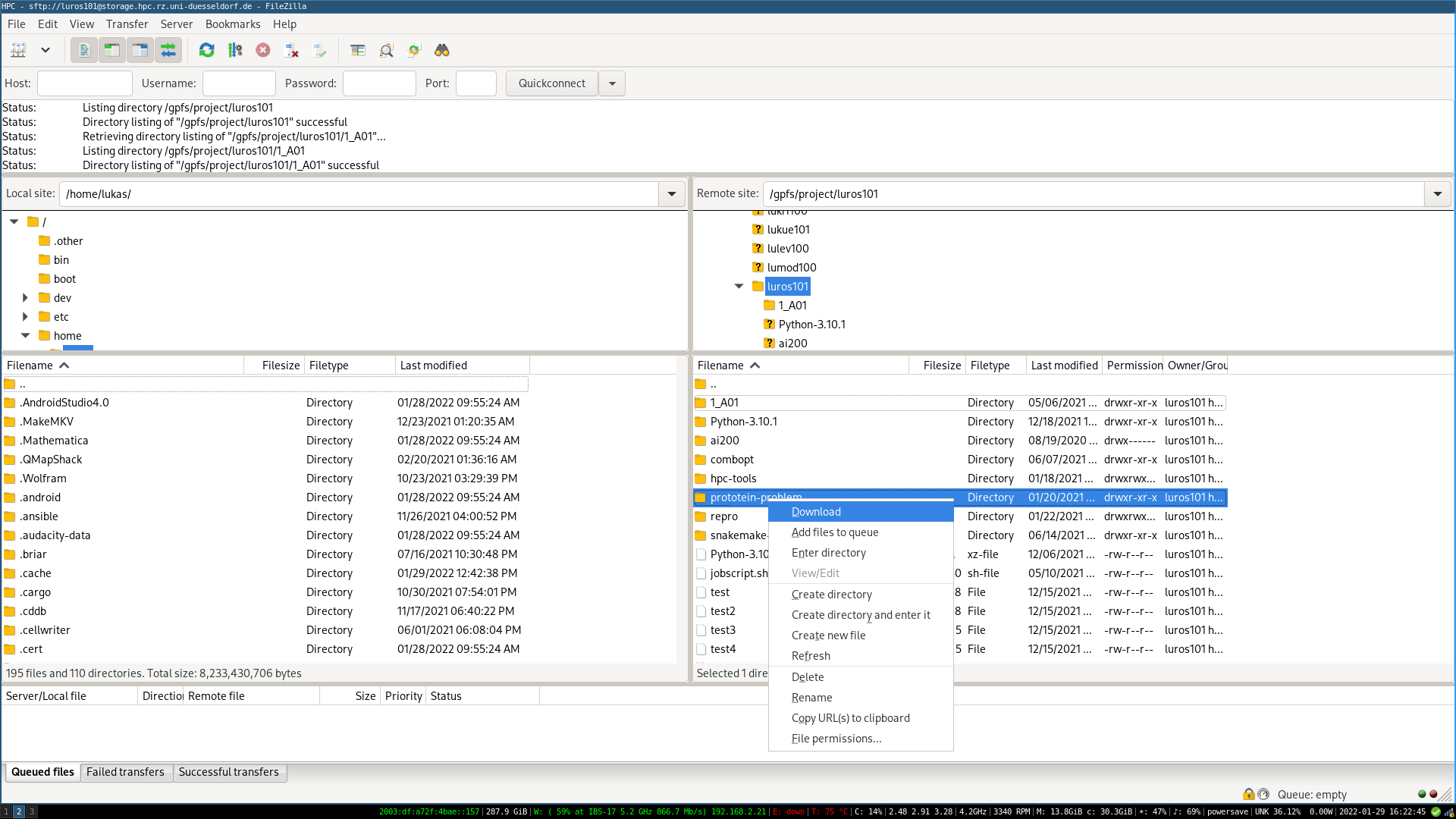

Als alternative Zugriffsmethode steht unter allen Betriebssystemen das SFTP-Protokoll bereit, was ähnlich zu den oben beschriebenen Methoden per SSHFS und `rsync` die Daten über das SSH-Protokoll überträgt. Dazu empfiehlt sich die Verwendung der Open Source-Software FileZilla, die unter https://filezilla-project.org/ heruntergeladen werden kann. Nach dem Start der Anwendung öffnet sich folgendes Fenster:

Das Fenster ist zweigeteilt, links werden die lokalen Ordner angezeigt, und rechts werden nach erfolgreicher Verbindung die Ordner auf dem HPC sichtbar sein.

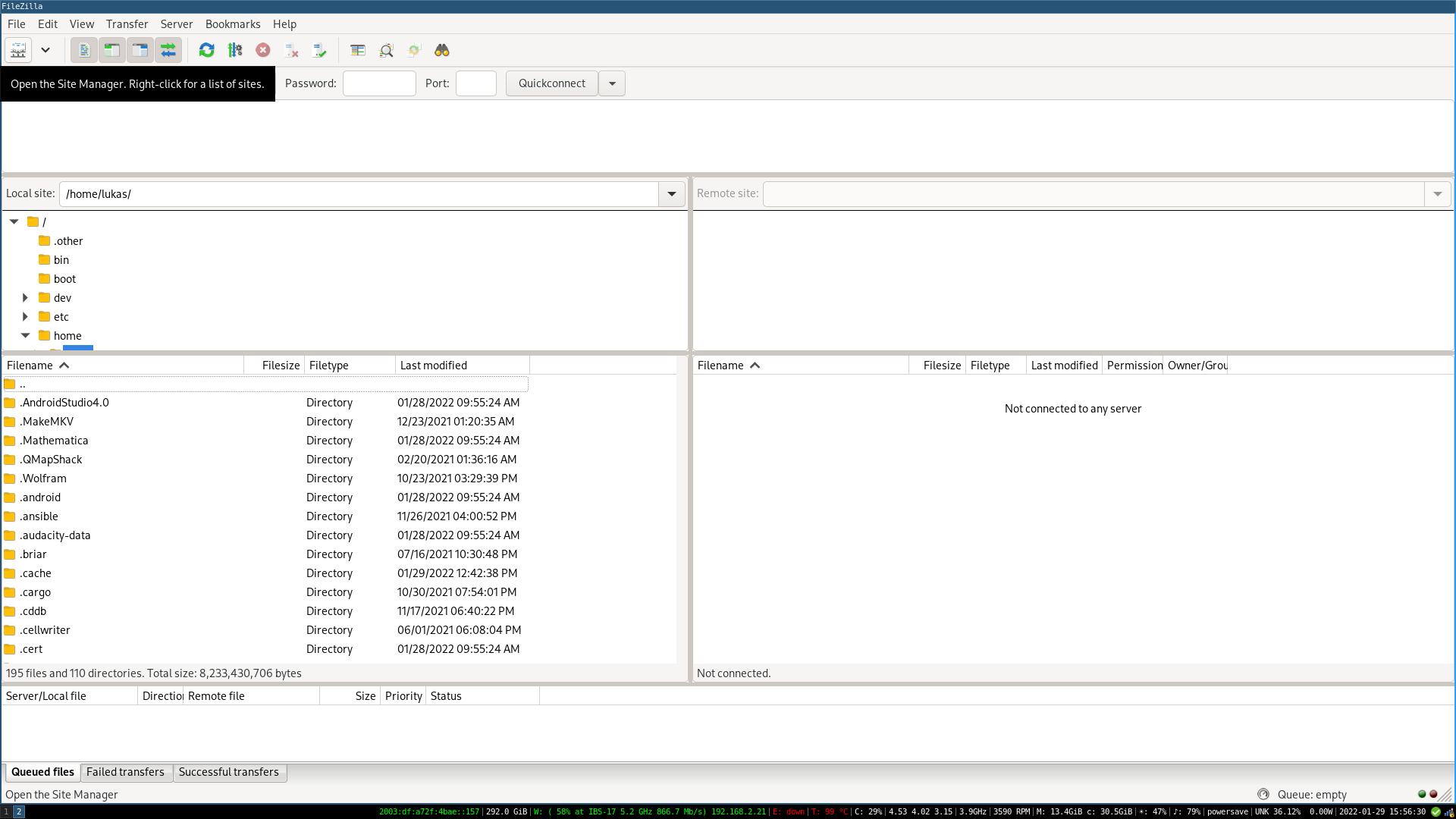

Mit einem Klick auf das Server-Symbol in der oberen linken Ecke kann der Server-Manager geöffnet werden.

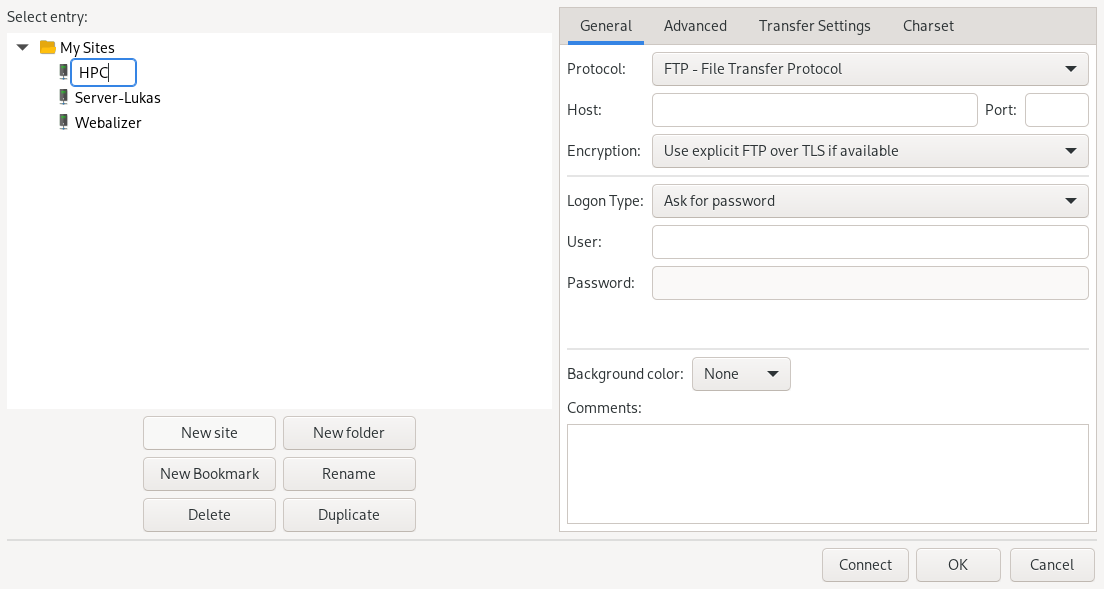

In diesem Fenster kann mit einem Klick auf "New site" eine neue Verbindung angelegt werden. Es empfiehlt sich, die Verbindung mit einem aussagekräftigen Namen zu benennen, in diesem Fall z.B. "HPC".

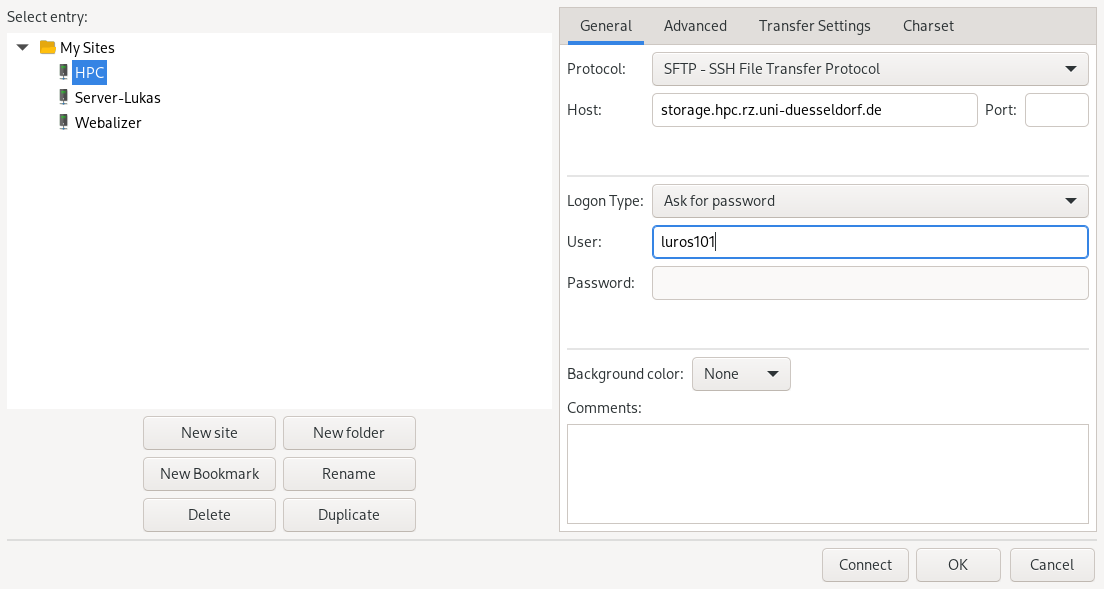

Anschließend müssen im rechten Teil des Fensters die Verbindungsparameter eingestellt werden. Als Protokoll muss "SFTP" verwendet werden (das "S" steht hierbei für die Verschlüsselung, und ist daher sehr wichtig, unverschlüsselte Verbindungen werden abgelehnt). Als Host bzw. Servernamen ist wie gewohnt storage.hpc.rz.uni-duesseldorf.de zu verwenden, und als Benutzername die eigene Unikennung.

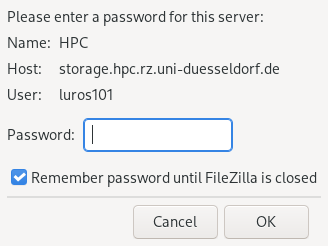

Mit einem Klick auf "Connect" bzw. "Verbinden" öffnet sich dieses Fenster, indem das Passwort abgefragt wird. Dort einfach das zur Unikennung gehörige Passwort eingeben, und mit "OK" bestätigen.

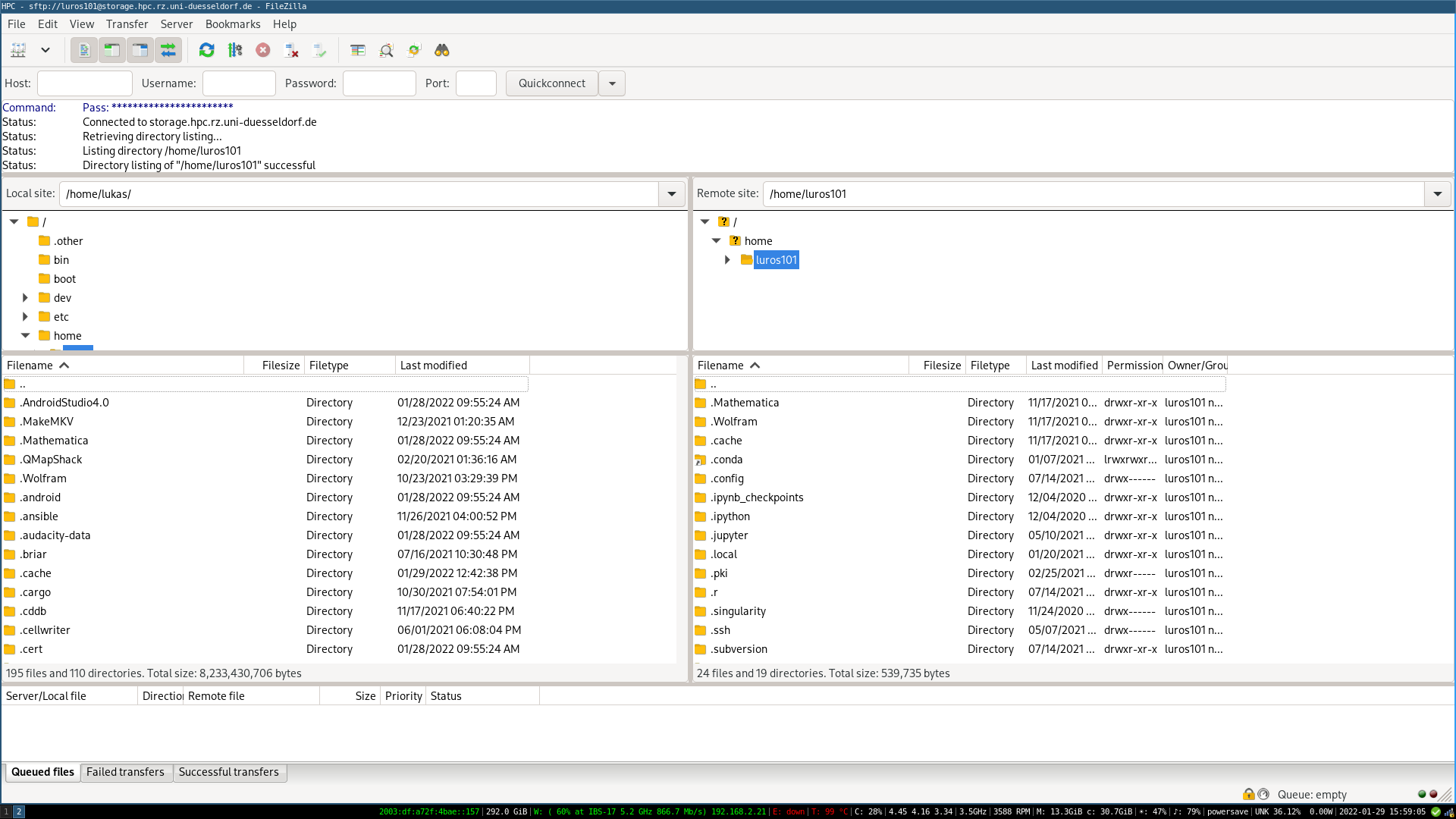

Anschließend wird die Verbindung zum HPC-Storage hergestellt, und die Verzeichnisstruktur im rechten Fenster angezeigt (kann beim ersten Verbindungsaufbau bis zu 20 Sekunden dauern). Das Startverzeichnis ist dabei immer das Home-Verzeichnis.

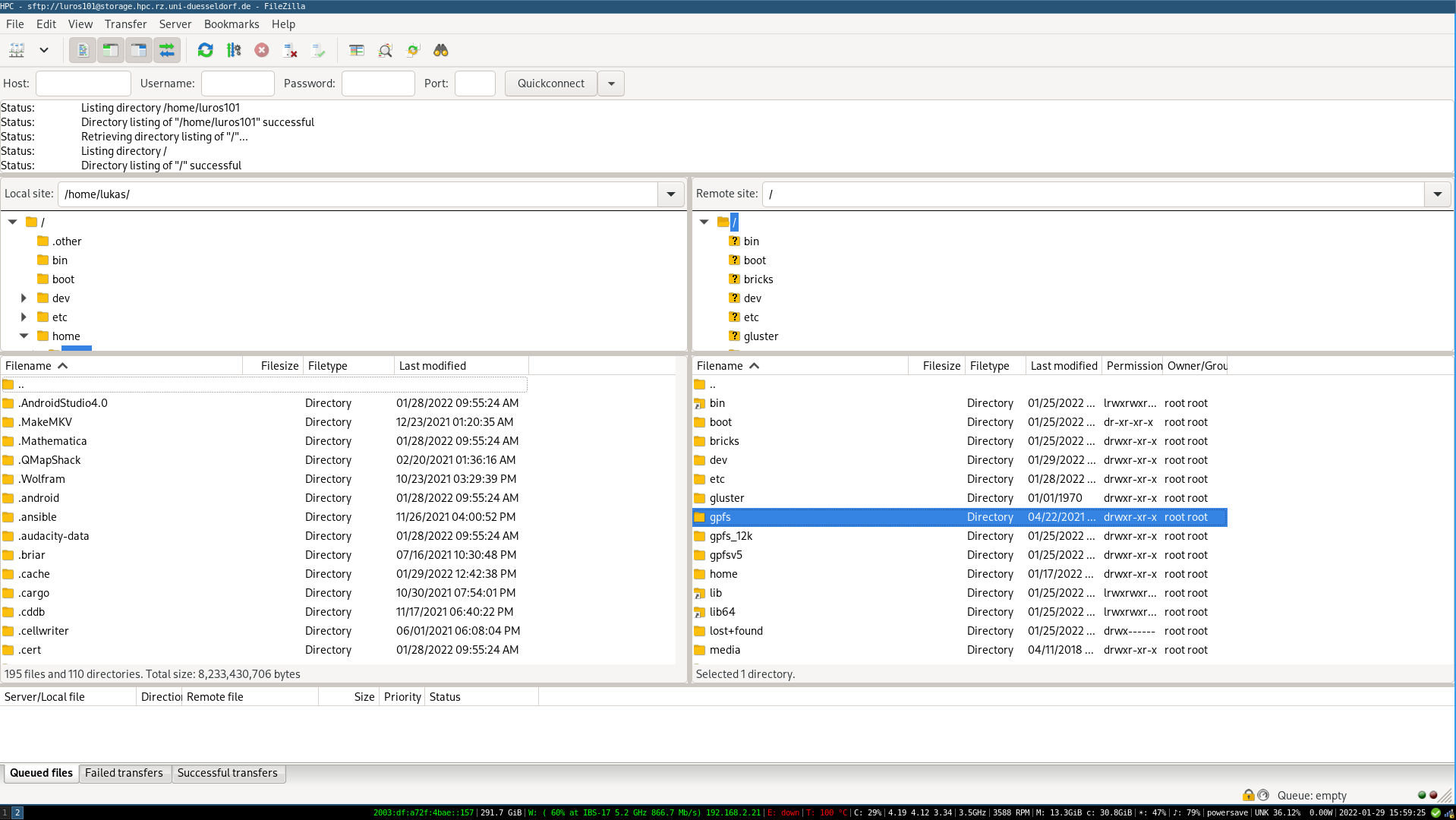

Um zum GPFS zu gelangen, kann mit einem Klick auf den Schrägstrich "/" im oberen Teil des Verzeichnisbaumes auf das Wurzelverzeichnis des HPC gewechselt werden. Anschließend kann im unteren Teil des Verzeichnisbaumes das Verzeichnis gpfs per Doppelklick geöffnet werden, und darin dann das Verzeichnis project.

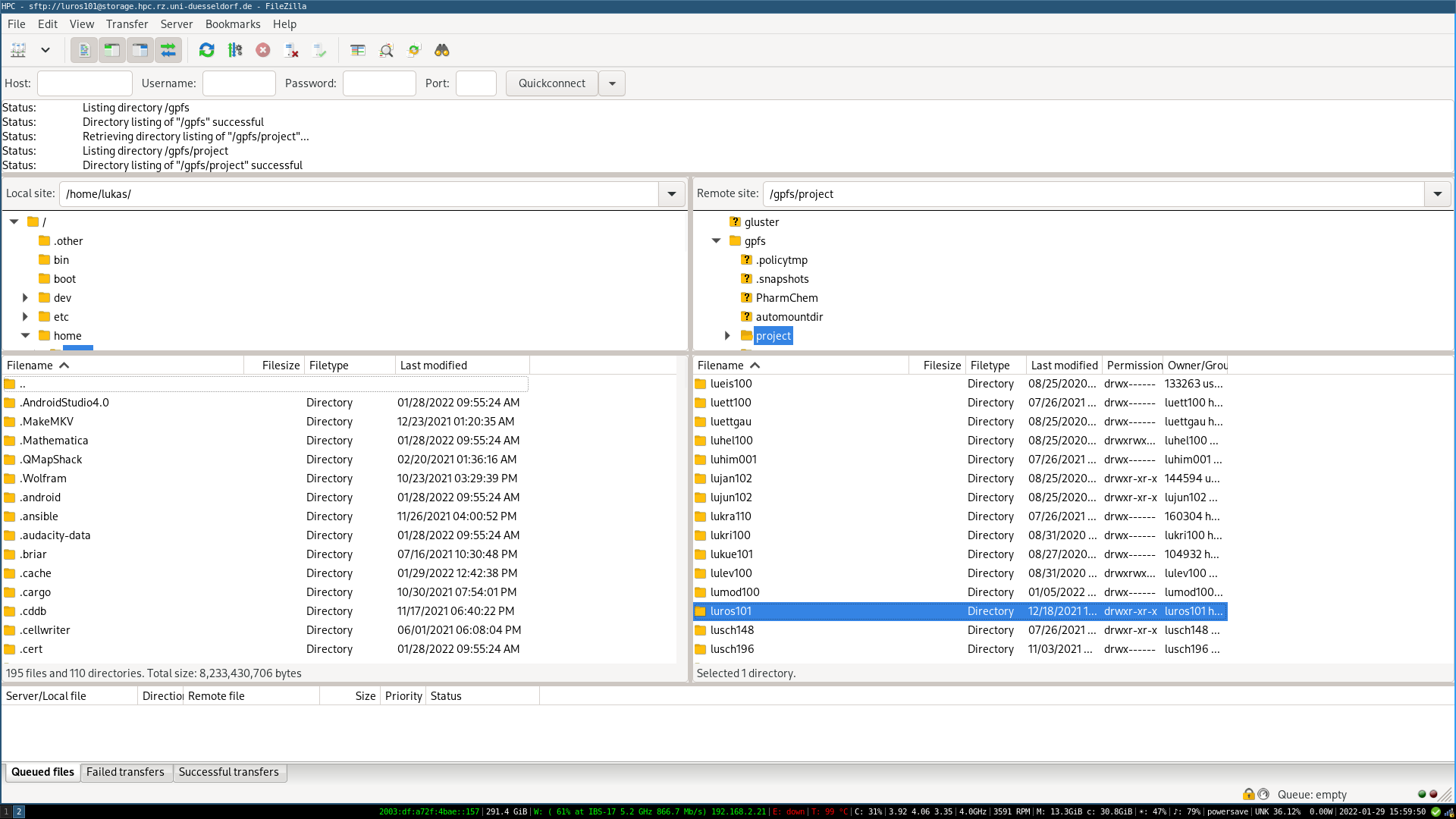

Danach sollte sich die Liste der Benutzerverzeichnisse öffnen, in dem das eigene Benutzerverzeichnis ausgewählt und durch Doppelklick geöffnet werden kann.

Dateien und Ordner können per Rechtsklick → Download oder per Drag and Drop heruntergeladen werden. Standardmäßig werden sie immer in das Verzeichnis gespeichert, was in der linken Hälfte geöffnet ist (beim Start ist das das lokale Benutzerverzeichnis). Der Übertragungsfortschritt wird im unteren Teil des Fensters angezeigt.

3 Kommentare

Brilhaus, Dominik sagt:

Please add the rsync details here as well. I know it shouldn't, but it took me forever to figure out what I missed...

rsync --list-only <user_name>@storage.hpc.rz.uni-duesseldorf.de:/gpfs/project/<user_name>/

Rose, Lukas sagt:

Brilhaus, Dominik I've seen your comment just now. I've added documentation for

sshfsandrsync, feel free to let us know if you're still missing something. If it's urgent, feel free to reach out via one of the methods described in Kontakt.Brilhaus, Dominik sagt:

Danke Rose, Lukas. Kein akuter Bedarf. War nur ein Vorschlag, da es für mehrere Nutzende interessant sein könnte.

Da ja auch viele internationale Forschende auf dem HPC arbeiten, würde es sich vielleicht auch lohnen, mal per deepl translator die Seiten auf Englisch anzubieten.